Ce nouveau modèle dédié aux conversations a été dévoilé lors de la conférence développeurs Google I/O. La Google I/O du mardi 18 mai a été l’occasion de dévoiler un nouveau modèle de langage baptisé LaMDA (Language Model for Dialogue Applications) qui signifie modèle de langage pour les applications de dialogue.

Il est présenté comme révolutionnaire, car il serait capable de nouer une conversation naturelle et fluide avec un humain.

LaMDA repose sur un réseau neuronal open-source développé par Google Research. Le modèle a été formé pour comprendre des phrases ou des paragraphes en portant attention à la façon dont chaque mot se rapporte aux autres.

Conversation avec Pluton

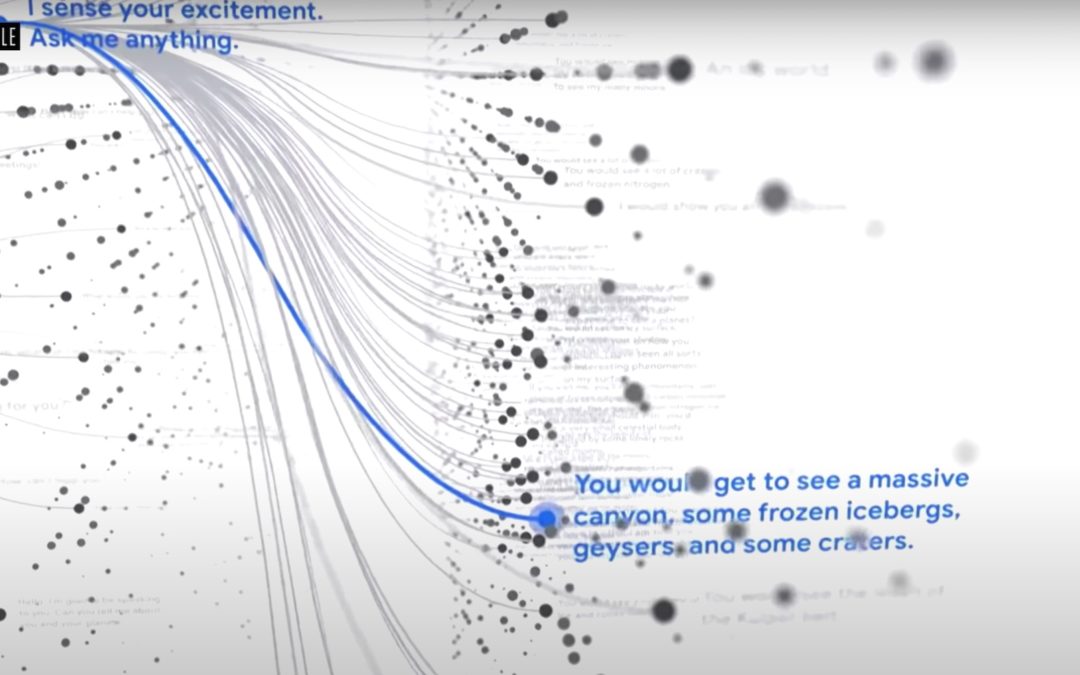

Google a réalisé deux démonstrations durant la conférence qui ont semblé un peu surréalistes, puisqu’il a été question de dialoguer avec la planète Pluton, puis avec un avion en papier ! À chaque fois, l’IA a fait preuve de solides connaissances sur les sujets évoqués, mais aussi d’une belle répartie et d’un certain humour, comme si elle était devenue réellement ces objets.

Pourquoi ne pas imaginer de telles conversations avec des écoliers pour rendre un cours de sciences plus vivant, par exemple ? Mais surtout, à ce que Guide entreprise l’a compris, si l’on interroge Google Assistant, on obtiendrait à l’avenir des réponses bien plus vivantes et engageantes que la lecture monocorde d’un article de Wikipedia.

Google affirme aussi avoir fait en sorte que les réponses soient factuellement correctes et éthiques. LaMDA viendra enrichir Google Assistant, mais aussi Search et Workspaces dans le futur.

Construire des modèles multimodaux par la suite…

« C’est un énorme pas en avant dans la conversation naturelle mais ce n’est pour l’instant entraîné que sur des textes et lorsque les gens communiquent ensemble, ils le font avec des images, du texte, de l’audio de la vidéo », a indiqué le CEO. Ceux-ci permettront par exemple de décrire une image ou une scène pour pouvoir la retrouver précisément au sein d’une vidéo.

Des questions se posent évidemment, comme pour toute utilisation de l’IA, sur les conséquences d’un mauvais usage de LaMDA, par la prise en compte de préjugés, de discours haineux ou par la reproduction de fausses informations.

Commentaires récents